FRIENDS,

इस पोस्ट में हम How to create and add custome Robots.txt file in

blogger in Hindi में जानकारी प्राप्त करेंगे. सभी bloggers or

webmasters की यह उत्कट इच्छा होती है कि उसका ब्लाग SEARCH

RESULT में top पर हो ताकि ब्लाग को अधिक से अधिक ट्राफिक मिल

सके.

और blog traffic increase करने के लिए हम हर सम्भव प्रयास भी करते हैं

और इसी प्रयास की एक और कडी के अन्तर्गत ब्लाग के लिए custom

robots.txt file create करना और ब्लाग के साथ add करना अत्यन्त हीं

आवश्यक होता है. आप चाहे कितना भी अच्छा content लिखें लेकिन जब

तक organic traffic (जो हमें search engines जैसे google, bing etc. से

मिलता है) प्राप्त नहीं होता है तब तक हमें अपने ब्लाग की सफलता के बारे

में सोंचना कोरी मूर्खता से ज्यादा कुछ भी नहीं माना जा सकता है.

इस पोस्ट में हम How to create and add custome Robots.txt file in

blogger in Hindi में जानकारी प्राप्त करेंगे. सभी bloggers or

webmasters की यह उत्कट इच्छा होती है कि उसका ब्लाग SEARCH

RESULT में top पर हो ताकि ब्लाग को अधिक से अधिक ट्राफिक मिल

सके.

और blog traffic increase करने के लिए हम हर सम्भव प्रयास भी करते हैं

और इसी प्रयास की एक और कडी के अन्तर्गत ब्लाग के लिए custom

robots.txt file create करना और ब्लाग के साथ add करना अत्यन्त हीं

आवश्यक होता है. आप चाहे कितना भी अच्छा content लिखें लेकिन जब

तक organic traffic (जो हमें search engines जैसे google, bing etc. से

मिलता है) प्राप्त नहीं होता है तब तक हमें अपने ब्लाग की सफलता के बारे

में सोंचना कोरी मूर्खता से ज्यादा कुछ भी नहीं माना जा सकता है.

यदि आप एक blogger/blogspot user हैं और अपने ब्लाग की search

ranking increase करना चाहते हैं तो यह पोस्ट "How to create and

add custome Robots.txt file in blogger" अवश्य हीं पढे क्योंकि बिना

robots.txt file add किए आपके blog की traffic नहीं बढ सकती है.

इस पोस्ट को एक बार नहीं बल्कि मैं तो कहूंगा कि बार - बार पढें ताकि

robots.txt file create करने व उसे blogger blog में add करने में कोई

गलती नहीं हो पाए.

क्योंकि robot.txt file creation एक sensitive matter होता है और इसमें

हुई चुक का खामियाजा आपको भुगतना पड सकता है. गलत तरीके से

robot.txt file add करने से search reference से लाभ की जगह हानि

उठाना पड सकता है.

यदि आपको robot.txt file क्या होता है, के विषय में थोडी सी भी संशय

हो तो इसे छोड देना हीं हितकर है. जब तक आप इसके विषय में खूब

अच्छी तरह से नहीं समझ लेते हैं तब तक robot.txt file creation के

विषय में सोंचिए हीं नहीं. वरना फायदा की जगह नुकसान होने की

पूरी संभावना रहेगी.

और आपकी ब्लाग पोस्ट ना हीं search engine bots crawl कर पाएगी

और ना हीं index हो पाएगी. जबकि robot.txt file crawling and

indexing के लिए हीं create and add किया जाता है.

हालाकि इस बात से ज्यादा भयभीत होने की आवश्यकता भी नहीं है.

यदि आप concentrated mind से इस पोस्ट को पढें तो सब कुछ बडी

हीं आसानी से समझ सकते हैं.

ranking increase करना चाहते हैं तो यह पोस्ट "How to create and

add custome Robots.txt file in blogger" अवश्य हीं पढे क्योंकि बिना

robots.txt file add किए आपके blog की traffic नहीं बढ सकती है.

इस पोस्ट को एक बार नहीं बल्कि मैं तो कहूंगा कि बार - बार पढें ताकि

robots.txt file create करने व उसे blogger blog में add करने में कोई

गलती नहीं हो पाए.

क्योंकि robot.txt file creation एक sensitive matter होता है और इसमें

हुई चुक का खामियाजा आपको भुगतना पड सकता है. गलत तरीके से

robot.txt file add करने से search reference से लाभ की जगह हानि

उठाना पड सकता है.

यदि आपको robot.txt file क्या होता है, के विषय में थोडी सी भी संशय

हो तो इसे छोड देना हीं हितकर है. जब तक आप इसके विषय में खूब

अच्छी तरह से नहीं समझ लेते हैं तब तक robot.txt file creation के

विषय में सोंचिए हीं नहीं. वरना फायदा की जगह नुकसान होने की

पूरी संभावना रहेगी.

और आपकी ब्लाग पोस्ट ना हीं search engine bots crawl कर पाएगी

और ना हीं index हो पाएगी. जबकि robot.txt file crawling and

indexing के लिए हीं create and add किया जाता है.

हालाकि इस बात से ज्यादा भयभीत होने की आवश्यकता भी नहीं है.

यदि आप concentrated mind से इस पोस्ट को पढें तो सब कुछ बडी

हीं आसानी से समझ सकते हैं.

इसे भी पढें

WHAT IS ROBOTS.TXT

Robots.txt एक text file or code होता है जो search engines

bots

को यह समझाता है कि कौन सा पोस्ट या पेज को crawl and index

करना है.

एक तरह से robot.txt file को हम साइट-कंटेंट का गार्ड भी कह सकते

हैं. क्यों कि यह search engine robots जिसे हम crawler, bots, spider

इत्यादि नामों से भी जानते हैं, को यह आदेश देता है कि किस पेज या

पोस्ट को क्राउल करे और किसे नहीं करे.

यदि आप किसी particular post or page को disallow कर देते हैं तो

search engine उस particular page or post को index हीं नहीं करेगा.

को यह समझाता है कि कौन सा पोस्ट या पेज को crawl and index

करना है.

एक तरह से robot.txt file को हम साइट-कंटेंट का गार्ड भी कह सकते

हैं. क्यों कि यह search engine robots जिसे हम crawler, bots, spider

इत्यादि नामों से भी जानते हैं, को यह आदेश देता है कि किस पेज या

पोस्ट को क्राउल करे और किसे नहीं करे.

यदि आप किसी particular post or page को disallow कर देते हैं तो

search engine उस particular page or post को index हीं नहीं करेगा.

HOW TO WORK ROBOT.TXT -

SEARCH

ENGINE जैसे google हमेशा हीं web पर प्रतिदिन add होने

वाले new and fresh contents को महत्व देता है और इस निमित वह

अपने robots or spider को web पर नए fresh contents को crawl

करने के लिए भेजता है.

और इसी crawling के दरमियान आपके नए पोस्ट को भी crawl करता

है और उसे index करता है. यदि आपने अपने किसी खास content को

crawl करने से मना किया होगा तो वह उसे ना हीं crawl करेगा और ना

हीं index करेगा.

वाले new and fresh contents को महत्व देता है और इस निमित वह

अपने robots or spider को web पर नए fresh contents को crawl

करने के लिए भेजता है.

और इसी crawling के दरमियान आपके नए पोस्ट को भी crawl करता

है और उसे index करता है. यदि आपने अपने किसी खास content को

crawl करने से मना किया होगा तो वह उसे ना हीं crawl करेगा और ना

हीं index करेगा.

HOW DOES ROBOT.TXT LOOK LIKE

User-agent:

Mediapartners-Google

Disallow:

User-agent:

*

Disallow:

/search

Allow: /

उपरोक्त sentences में कुछ words हैं जिनके विषय में भी जानकारी

रखना बहुत हीं आवश्यक है.

तो आईए इन शब्दों के महत्व को समझते हैं -

रखना बहुत हीं आवश्यक है.

तो आईए इन शब्दों के महत्व को समझते हैं -

User-agent: Mediapartners-Google -

- Mediapartners-Google

- यह Google Adsense का robot / spider है

जो कि adsense ads को crawl and indexing के लिए होता है.

इसके द्वारा adsense crawler niche related advertisements को

display करने के लिए प्रयुक्त होता है.

जो कि adsense ads को crawl and indexing के लिए होता है.

इसके द्वारा adsense crawler niche related advertisements को

display करने के लिए प्रयुक्त होता है.

यदि आपके ब्लाग का adsense approval नहीं हुआ है तो simply इस

sentence -

sentence -

User-agent:

Mediapartners-Google

को robot.txt file से remove कर दें.

User-agent: *

यहां user-agent: के बाद में एक asterisk

(*) add किया हुआ है जिसका

अर्थ होता है - all allowed. यानि यह हरेक प्रकार के robots or spiders/

bots को blog-content को crawl करने के लिए कहता है.

अर्थ होता है - all allowed. यानि यह हरेक प्रकार के robots or spiders/

bots को blog-content को crawl करने के लिए कहता है.

-Disallow: /search

यदि आप किसी खास पोस्ट , पेज या लेबल को robot के द्वारा crawl or

index नहीं करवाना चाहते हैं तो यहां उस खास पोस्ट या पेज को

specify करके disallow कर सकते है.

index नहीं करवाना चाहते हैं तो यहां उस खास पोस्ट या पेज को

specify करके disallow कर सकते है.

उदाहरण -

Allow: /

यह ब्लाग के home page को crawl करने का आदेश देता है. और यदि

आपने किसी url को disallow किया है तो उस disallowed url को

छोडकर बाकी के जितने भी urls होंगे उसे search engine bots crawl

and index करते हैं.

आपने किसी url को disallow किया है तो उस disallowed url को

छोडकर बाकी के जितने भी urls होंगे उसे search engine bots crawl

and index करते हैं.

Sitemap:

यहां sitemap add करने का मतलब होता कि search engine bots हरेक

नए url को crawl and index करे.

By default गूगल सर्च-इंजन केवल 25 पोस्ट को हीं index करता है.

अतः यहां specify करना पडता है कितने urls को search engine

index करे.

नए url को crawl and index करे.

By default गूगल सर्च-इंजन केवल 25 पोस्ट को हीं index करता है.

अतः यहां specify करना पडता है कितने urls को search engine

index करे.

अतः पहली बार में हम search engine को कम से कम 500 urls को

index करने के लिए कह सकते हैं . और इसके लिए हमें निम्नलिखित

code or sentence add कर सकते हैं.

index करने के लिए कह सकते हैं . और इसके लिए हमें निम्नलिखित

code or sentence add कर सकते हैं.

यदि 500 से अधिक urls को index करवाना हो तो हम एक और

sentence add कर सकते हैं.

उदाहरण -

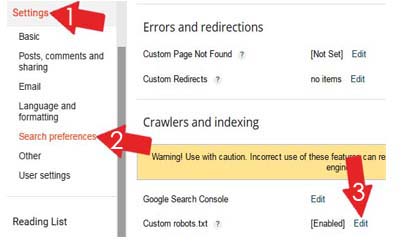

Adding Custom rebots.txt File to Blogger

- सबसे पहले अपने blogger account को sign in करें.

- उसके बाद setting >>

search preferences को क्लिक करें.

- अब custom robot.txt में Edit को क्लिक करें.

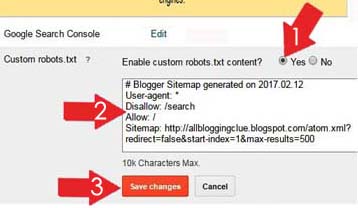

-Enable

custom robots.txt content के radio button - yes को सेलेक्ट

करें.

करें.

- अब created robot.txt

code को box में paste कर दें.

- सबसे अन्त में save setting पर क्लिक कर दें.

नोट -

Sitemap में xyz.blogspot.com के स्थान पर आप अपने ब्लाग का url add करें.

friends, यह पोस्ट

"How to create and add custome Robots.txt file in blogger in Hindi"

आपको कैसा लगा ?

यदि यह पोस्ट "How to create and add custome Robots.txt file in blogger in Hindi"

आपको पसन्द आई हो तो इसे social sites पर शेयर जरुर करें.

इसी तरह के useful content को अपने ईमेल पर प्राप्त करने के लिए ब्लाग को

subscribe करना नहीं भूलें.

इस पोस्ट से सम्बन्धित कोई समस्या हो तोcomment section में सवाल कर सकते

हैं. मैं आपके लिए solutions देने में खुद को गौरवांवित महसूस करुंगा.

धन्यवाद.

"How to create and add custome Robots.txt file in blogger in Hindi"

आपको कैसा लगा ?

यदि यह पोस्ट "How to create and add custome Robots.txt file in blogger in Hindi"

आपको पसन्द आई हो तो इसे social sites पर शेयर जरुर करें.

इसी तरह के useful content को अपने ईमेल पर प्राप्त करने के लिए ब्लाग को

subscribe करना नहीं भूलें.

इस पोस्ट से सम्बन्धित कोई समस्या हो तोcomment section में सवाल कर सकते

हैं. मैं आपके लिए solutions देने में खुद को गौरवांवित महसूस करुंगा.

धन्यवाद.

RECOMMENDED POSTS FOR YOU

0 Comments